Los analistas de datos son los detectives modernos. Examinan montañas de datos en busca de pistas para responder preguntas críticas de negocio. Su herramienta principal no es una lupa, sino un motor de consulta. En esencia, un motor de consulta es un software sofisticado que toma una solicitud del usuario, normalmente escrita en SQL, y recupera eficientemente los datos correspondientes del almacenamiento.

Durante la década de 2010, la historia de los datos fue una cuestión de escala. “Big Data” no era solo una palabra de moda; era una realidad que llevó nuestra tecnología al límite. El enorme volumen, velocidad y variedad de datos desbordó a las máquinas individuales, lo que llevó a una conclusión inevitable: si no puedes escalar verticalmente, debes escalar horizontalmente. Esto dio lugar a los motores de consulta distribuidos, que dividen los datos y la carga de procesamiento entre un amplio conjunto de computadoras.

Sin embargo, una tendencia contraria fascinante está ganando fuerza. Está surgiendo una nueva generación de motores de consulta de un solo nodo altamente optimizados, que están llamando la atención por su increíble rendimiento. Nombres como DuckDB o Apache DataFusion son cada vez más comunes en los círculos de ingeniería de datos.

Esto plantea una pregunta importante: en una industria que ha invertido tanto en computación distribuida, ¿por qué hay un resurgimiento tan fuerte de herramientas diseñadas para funcionar en una sola máquina? ¿Estamos retrocediendo? La respuesta corta es no. Este cambio no es una regresión; es una evolución pragmática y poderosa impulsada por avances tanto en hardware como en software. Veamos por qué.

La era de los sistemas distribuidos

Para entender el cambio actual, debemos mirar atrás al problema que definió los últimos quince años de la ingeniería de datos. A principios de los años 2000, empresas como Google y Yahoo estaban generando datos (registros de búsqueda, flujos de clics) a una escala que simplemente no podía almacenarse físicamente en el disco duro de una sola máquina. La solución fue “escalar horizontalmente”: en lugar de una máquina masiva, se podía utilizar un clúster de cientos o miles de computadoras baratas y comunes.

Esta nueva realidad exigió un cambio de paradigma completo. La idea fundamental era desacoplar el almacenamiento del procesamiento. Los datos se fragmentaban y distribuían en un sistema de archivos distribuido (como HDFS de Hadoop), y la lógica de procesamiento se enviaba a los nodos donde residían los datos. Apache Hadoop surgió como el conjunto de herramientas de código abierto para este mundo, popularizando el modelo MapReduce para ejecutar cálculos en paralelo a través del clúster.

Aunque poderoso, este era un mundo construido por y para ingenieros de software. Para los analistas de datos, era inaccesible. El gran avance llegó con herramientas como Apache Hive, que ofrecían una interfaz SQL familiar sobre el backend distribuido. Los analistas podían escribir SQL, y Hive lo traducía en complejos trabajos distribuidos. El ecosistema continuó evolucionando con Apache Spark, que abordó los cuellos de botella de rendimiento de los sistemas iniciales. Al introducir el concepto de procesamiento en memoria mediante Resilient Distributed Datasets (RDDs), Spark hizo que todo fuera mucho más rápido y flexible, consolidando su papel como el motor preferido para el procesamiento de datos a gran escala, aprendizaje automático y más. Este enfoque distribuido se convirtió en el estándar indiscutible para cualquier trabajo serio con datos.

Los problemas de un mundo centrado en sistemas distribuidos

El ecosistema distribuido, a pesar de su potencia, introdujo una fricción significativa. El problema principal es que los sistemas distribuidos son brutalmente complejos y costosos. Gestionar un clúster de nivel de producción requiere conocimientos técnicos especializados y conlleva altos costes operativos, tanto por la infraestructura como por los equipos necesarios para mantenerla. Esta complejidad se aplicó con frecuencia a problemas que no lo justificaban. La obsesión de la industria por el “big data” llevó al uso de estos pesados frameworks para conjuntos de datos en rangos de gigabytes o terabytes bajos—una escala en la que la sobrecarga del intercambio de datos por red a menudo hacía que las consultas fueran más lentas y más frágiles que una alternativa de nodo único.

Esta reevaluación está impulsada por dos tendencias clave. Primero, el hardware ha evolucionado drásticamente. Un servidor moderno es una auténtica potencia, fácilmente configurable con más de 100 núcleos de CPU, terabytes de RAM y almacenamiento NVMe ultrarrápido. La escalabilidad vertical vuelve a ser potente y rentable, ya que una sola máquina hoy puede superar a todo un clúster de hace una década.

Segundo, los motores emergentes se construyen con una filosofía de software diferente. Muchos sistemas heredados basados en la JVM sufren pausas impredecibles de recolección de basura (“stop-the-world”) que perjudican la latencia de las consultas. En cambio, los nuevos motores escritos en lenguajes como Rust o C++ ofrecen control directo sobre la memoria. Esto les permite eliminar la sobrecarga del GC y aprovechar al máximo las funciones modernas de CPU como el procesamiento vectorizado (SIMD), exprimiendo cada gota de rendimiento del hardware subyacente de una forma mucho más sencilla de lograr en una sola máquina.

Aquí es donde proyectos como Apache Arrow se vuelven transformadores. Arrow no es una base de datos ni un motor — es un formato de datos en memoria compartido que estandariza cómo se representa la información columnar en memoria. Su diseño está cuidadosamente optimizado para la caché y el SIMD, almacenando cada columna como arrays contiguos y tipados que las CPUs pueden procesar directamente en lotes. Lo más importante es que Arrow permite mover datos entre herramientas — desde capas de almacenamiento hasta motores de ejecución y bibliotecas de ciencia de datos — sin necesidad de serialización ni copias. Todos hablan el mismo lenguaje en memoria.

Esa interoperabilidad sin copias elimina uno de los mayores cuellos de botella en los sistemas de datos: la constante codificación y decodificación entre componentes. Con Arrow, los motores analíticos pueden operar directamente sobre datos residentes en memoria usando núcleos vectorizados, agilizando la ejecución y minimizando la sobrecarga de CPU. El resultado es que una sola máquina puede manejar cargas de trabajo que antes estaban reservadas para clústeres — no por fuerza bruta, sino gracias a un mejor diseño de datos y una computación más inteligente.

En resumen, los formatos eficientes en memoria y la ejecución vectorizada se han convertido en la nueva frontera de escalabilidad. Cambian la pregunta de “¿Cómo distribuimos esto?” a “¿Qué tan eficientemente puede una máquina usar su hardware?”. El resultado es una pila analítica más rápida, sencilla y fácil de mantener — que prospera no con más máquinas, sino con mejor diseño.

Motores de consulta emergentes: una nueva generación

Esta nueva ola de motores de consulta de un solo nodo no es un bloque uniforme; es un ecosistema diverso de herramientas, cada una con su propia filosofía y fortalezas. Un ejemplo destacado de este nuevo enfoque es Apache DataFusion. DataFusion se describe mejor como un framework extensible de ejecución de consultas, escrito en Rust. Proporciona los componentes fundamentales—el analizador, el optimizador de consultas y el motor de ejecución—para construir sistemas de datos de alto rendimiento. No lo pienses como un coche terminado, sino como un motor y chasis de alto rendimiento que puedes usar para construir tu propio vehículo personalizado.

¿Qué lo hace diferente? Su poder radica en su modularidad y extensibilidad, construida sobre los cimientos de Apache Arrow. Al ser una biblioteca y no una aplicación independiente, los desarrolladores pueden integrar DataFusion directamente en sus propias aplicaciones. Una empresa que esté creando una nueva herramienta de BI, un framework personalizado de calidad de datos o incluso una nueva base de datos puede aprovechar el motor de ejecución vectorizado y probado de DataFusion sin tener que construir uno desde cero. Esto reduce drásticamente la barrera para crear aplicaciones de alto rendimiento y centradas en datos.

Pero veámoslo desde el punto de vista de un analista: imagina que estás trabajando en un notebook con un archivo Parquet grande y necesitas ejecutar consultas complejas sin montar un clúster distribuido. Aquí es donde DataFusion brilla. Puedes cargar el archivo localmente y ejecutar consultas SQL directamente sobre él, aprovechando la ejecución vectorizada y el formato en memoria de Arrow para obtener resultados rápidos y eficientes. Sin necesidad de configurar Spark, sin preocuparte por la infraestructura—solo tú, tu notebook y una herramienta que maximiza el rendimiento del hardware moderno.

Apache DataFusion

Si eres un analista de datos frente a un archivo Parquet de varios gigabytes — demasiado grande para que Pandas lo maneje cómodamente, pero lo suficientemente pequeño como para caber en memoria — DataFusion podría ser justo lo que necesitas.

Con los bindings de Python (paquete datafusion), puedes iniciar un motor de consultas SQL dentro de tu notebook con solo unas pocas líneas de código. Sin servidores, sin clústeres, sin dolores de cabeza de configuración — solo SQL de alto rendimiento sobre archivos locales.

from datafusion import SessionContext

ctx = SessionContext()

ctx.register_parquet("data", "my_big_file.parquet")

df = ctx.sql("""

SELECT category, SUM(revenue) AS total_revenue

FROM data

WHERE date >= '2024-01-01'

GROUP BY category

ORDER BY total_revenue DESC

""")

df.show()

Internamente, DataFusion utiliza Apache Arrow para su diseño columnar en memoria y ejecución vectorizada para aprovechar al máximo las CPUs modernas. El resultado: consultas analíticas complejas que se ejecutan a velocidad casi compilada — muchísimo más rápido que Pandas, PySpark o Dask para cargas de trabajo estilo SQL.

Es ideal para:

- Explorar grandes conjuntos de datos Parquet localmente sin necesidad de configurar Spark o Presto.

- Ejecutar agregaciones y joins SQL pesados directamente desde Python.

- Integrar análisis en aplicaciones ligeras o scripts ETL donde necesitas toda la potencia de SQL, no solo dataframes.

Un ejemplo concreto: ClickBench

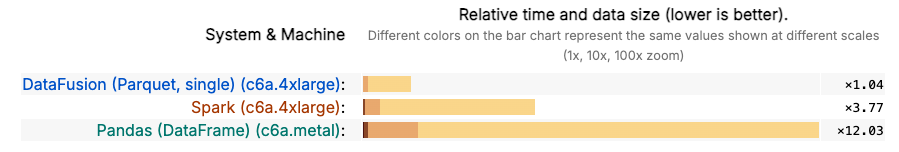

Para entender cómo se comparan los motores modernos de un solo nodo con los sistemas distribuidos, es útil observar un benchmark realista — no micropruebas sintéticas, sino algo que refleje el trabajo analítico del mundo real. El benchmark ClickBench es un excelente ejemplo. Utiliza 13,8 GB de datos Parquet comprimidos que representan registros anónimos de clics y tráfico de una de las plataformas de analítica web más grandes del mundo. El benchmark está compuesto por 42 consultas que capturan los patrones esperados en el análisis de clics, analítica web y de tráfico, registros generados por máquinas y datos de eventos en tiempo real — el tipo de cargas de trabajo que alimentan consultas ad-hoc y dashboards en muchas pilas analíticas modernas.

En el conjunto de datos de ClickBench, la diferencia de diseño entre un framework centrado en lo distribuido como PySpark y uno altamente optimizado de nodo único como DataFusion se vuelve muy evidente. Mientras PySpark necesita iniciar su contexto de ejecución local, analizar los trabajos y programar tareas, DataFusion puede simplemente abrir los archivos Parquet y comenzar a ejecutar consultas de inmediato. Para análisis ad-hoc y exploración iterativa, esa capacidad de respuesta supone un gran impulso a la productividad. En la práctica, la mayoría de las consultas tipo ClickBench — agregaciones, filtros, joins y group-bys — se completan significativamente más rápido en DataFusion cuando se ejecutan en una estación de trabajo moderna con suficiente RAM, sin necesidad de configurar ningún clúster.

Para completar la comparación, también se ha enfrentado DataFusion con otro motor local muy conocido: Pandas. DataFusion supera ampliamente a Pandas en rendimiento, lo que resalta la importancia del diseño altamente optimizado de Apache Arrow para la computación en memoria, sobre el cual se basa DataFusion.

Conclusiones: La herramienta adecuada para el trabajo

El regreso de los motores de consulta de un solo nodo no es un paso atrás hacia el pasado; es un salto hacia un futuro más pragmático y eficiente. La industria está madurando, dejando atrás la mentalidad de “big data para todo” que dominó la década anterior. Estamos redescubriendo una verdad fundamental de la ingeniería: usar la herramienta más simple que pueda hacer el trabajo de manera efectiva.

Esta evolución está impulsada por dos grandes fuerzas: las increíbles capacidades de escalado vertical del hardware moderno y una nueva generación de software diseñado desde cero para aprovecharlas. Estos motores están extrayendo un rendimiento de una sola máquina que antes era inimaginable.

El futuro no es una elección entre sistemas distribuidos y de nodo único. Es un mundo híbrido donde se elige la arquitectura adecuada según el problema a resolver.

- Para análisis interactivos sobre conjuntos de datos que van desde gigabytes hasta terabytes bajos, para aplicaciones embebidas y para desarrollo rápido, la simplicidad, velocidad y bajo coste operativo de motores de nodo único como Apache DataFusion o DuckDB serán insuperables.

- Para almacenamiento de datos a escala de petabytes, lagos de datos masivos y cargas de trabajo que requieren alta tolerancia a fallos y acceso concurrente, el paradigma distribuido de Spark y similares seguirá siendo el campeón indiscutible.

El detective de datos moderno ahora cuenta con un conjunto de herramientas más sofisticado. En lugar de recurrir al mazo industrial de un clúster distribuido para cada problema, ahora puede elegir el bisturí preciso y de alto rendimiento de un motor de nodo único. Este cambio les permite encontrar respuestas más rápido, de forma más eficiente y con menos fricción, permitiéndoles centrarse en lo que realmente importa: resolver el misterio oculto en los datos.

Leave a Reply